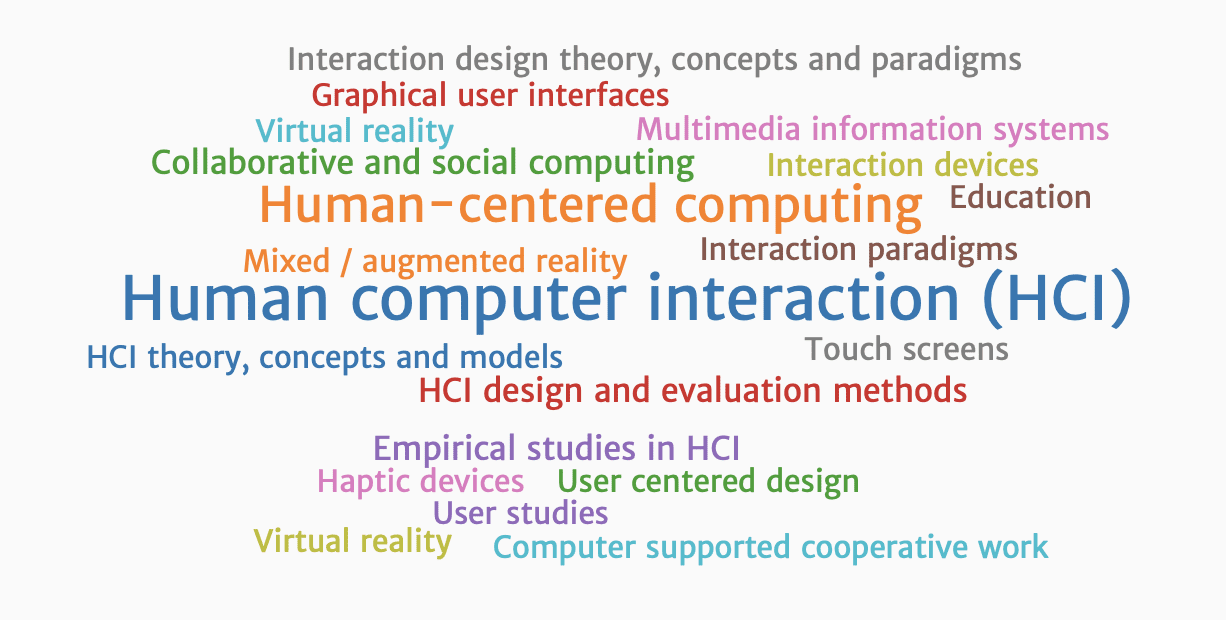

让计算机能听、能说、能看、能感觉,是未来人机交互(Human-computer interaction,HCI)的发展方向,其中语音已成为未来最被看好的人机交互方式,语音比其他的交互方式有更多的优势。目前,语音服务存在于各种场景中,包括实时会议记录、视频实时直播字幕、呼叫中心语音质检、实时会议记录等。

语音人机交互

语音人机交互主要涉及自动语音合成(Text to Speech,TTS)和自动语音识别(ASR),它们互为逆过程,涉及声学、语言学、数字信号处理和计算机科学。新型的呼叫中心使用

自动语音合成(Automatic Speech Synthesis)技术又称为文本转语音(TTS)技术,它可以将任何文字信息转换成标准流畅的语音且进行朗读。TTS

自动语音识别(Automatic Speech Recognition,ASR)技术又称为语音转文本

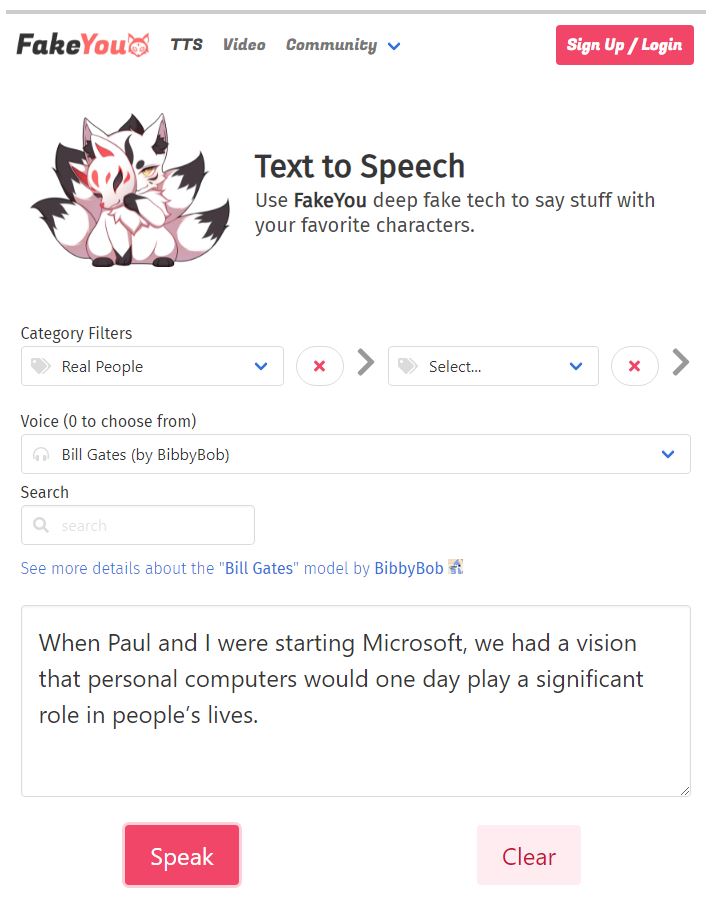

FakeYou Text to Speech 本质是一个

图中我们让

英伟达发布了 NVIDIA Riva 对话式 AI 应用服务框架,是一个 GPU 加速的 SDK,整合了 TTS 和 ASR 等智能算法引擎,提供现成的语音服务,旨在帮助用户轻松、快速地访问会话 AI 功能。

雷达 vs. 摄像头

再以自动驾驶为例说明计算机

自动驾驶系统分为三个层级:感知层、决策层和执行层。感知层收集周围的环境信息并做出预处理;决策层类似于人类的大脑,会基于感知层获取的信息,做出任务规划、行为决策和动作规划;执行层负责精准地执行决策层规划好的动作。其中,环境感知是全面实现自动驾驶的关键一环,为实现环境感知,雷达(超声波雷达、毫米波雷达、激光雷达)和摄像头的路线之争正酣。绝大多数车企利用激光雷达(Laser Detecting and Ranging,LiDAR)可提供高分辨率、高精度和抗有源干扰能力强的几何图像、距离图像、速度图像等特点,均有激光雷达搭载计划(包括通用汽车的

大脑对眼睛的视觉信号进行大量的后期处理,并试图创建一个向量空间。基于这个原理,特斯拉的

更进一步,人类的大脑有时超越了向量空间,变成概念空间,这就要求自动驾驶系统建立向量空间,然后对这些空间进行实际预测。

比如当你开车时,前面有一辆卡车,还有一些孩子准备过马路,当你距离卡车较近的时候,卡车挡住了你的视线,你看不到那些小孩了。这时,你心里想的是这些孩子现在在什么位置,需要提前预测一下(位置)。

特斯拉投入巨量资源重写了算法的

实际上,还有雷达

楼主残忍的关闭了评论